10 trucos para blogs: Conseguir más visitas

A todos nos cuesta aumentar el tráfico de visitas de nuestro blog, página web o negocio, pero es algo especialmente difícil para los que están comenzando. Obviamente, aumentar nuestro tráfico es algo prioritario y totalmente imprescindible para conseguir darnos a conocer.

Existen multitud de manuales para aumentar el tráfico de nuestra página, sin embargo, en la mayoría existen puntos con los que no estoy de acuerdo, o consideraciones que pasan inadvertidas o se obvian por completo. Con este manual quiero mostrar al público 10 consejos para mejorar nuestro blog (siempre desde mi punto de vista).

La mayoría de los blogs con un buen tráfico de visitas (a veces ni eso, simplemente indexados en Google), pueden obtener una gráfica similar a la siguiente:

La porción grande representa los accesos diarios desde un buscador: Google (más de un 85%) y del restante 15% aproximado, sólo un 5% de accesos a la página principal directamente. Esto nos muestra la importancia de «caerle» bien a un buscador.

Teniendo esto en cuenta, ahora lo que necesitamos es fortalecer esa «simpatía» con el buscador para conseguir que nos indexe en los puestos más altos de cualquier keyword (palabra clave buscada) y por lo tanto recibir más visitas. Con estos consejos intentaremos «fidelizar» a los usuarios que lleguen, que se sientan a gusto en nuestra página y deseen volver o visitarla a menudo.

Publica entradas frecuentemente

Cuantos más artículos publiques, más contenido tendrá tu blog, y cuanto más contenido, un campo más amplio de posibilidades de que lleguen más visitas... Pero ¡Ojo! No se trata de cualquier tipo de contenido, hay que intentar mejorar el blog generando contenido de calidad (no dupliques entradas, no copies artículos, genera artículos propios, etc...).

Cada vez que actualices puedes realizar pings en multitud de servicios de ping para blogs como pingoat o ping-o-matic. ¡Usalos sólo cuando actualices!

Antes era aconsejable realizar estos pings para «avisar» del contenido fresco y actualizado. Hoy en día, basta con darte de alta en Google Webmaster Tools (ver más adelante) para realizar un seguimiento de nuestras actualizaciones en Google.

Optimiza tu fichero robots.txt

El fichero robots.txt existe en el raíz de todo buen blog. Muchos de los robots buscadores de la red, visitan este fichero para saber que páginas del sitio se le permiten indexar y cuales no.

En algunos casos comentan que sólo optimizando el fichero robots.txt [en] han conseguido aumentar el tráfico en más de un 1400%.

Puedes encontrar un artículo que explica detalladamente que es el fichero robots.txt y como se utiliza en Robots.txt: Todo lo que debería saber.

Controla con estadísticas

Si hay un apartado que todo blogger suele controlar es este. Ten al menos un servicio de estadísticas para controlar cuantos usuarios llegan a tu blog, porque palabras clave (útil para saber si estás usando buenos títulos de post si encajan con el contenido de tu blog), con que navegadores, etc... Mis preferidos (y gratuitos) son StatCounter y Google Analytics.

Además, si tienes Google Analytics puedes aplicar un pequeño truco para controlar el número de clics en banners de Adsense por día, semana... o incluso desde que páginas.

Posicionamiento/SEO

Quizás uno de los apartados más complejos, a los que menos se le hace caso y sin duda de los más importantes. Google (y otros buscadores) tienen una serie de «normas» para clasificar las páginas en orden de importancia, cuanto mejor las sigas, mejores resultados obtendrán a la hora de posicionarte en Google.

Ahí van las más conocidas:

- Utiliza encabezados: A google le encanta que utilices encabezados h1, h2, h3, ... en el código HTML de tu página para remarcar títulos y zonas importantes.

- Títulos de página con guión: Intenta cambiar los títulos de tus páginas a cosas como page.com/art/google. Las páginas con títulos page.com/?id=20&titulo=google no le gustan y no las sigue.

- Metatags: Utiliza con responsabilidad los metatags. Aunque muchos opinan que no deben usarse, yo creo que los buscadores los tienen muy en cuenta (dependiendo de cual).

- Negritas: Anecdóticamente, el tag HTML b (negrita, en desuso por el W3C) es mucho más potente que el tag strong.

- Título de la página: Google le da muchísima importancia al título de la página. Elige bien las palabras a incluir en él. Aún veo páginas que tienen de título cosas como Untitled document o Página sin título.

- Otros trucos de posicionamiento...

Evitar técnicas de spam

Algo a lo que Google le da muchísima importancia es a la popularidad. Conseguir muchos enlaces en otras páginas hacen que Google te suba en su «ranking» de posiciones. Esto, por una parte es un buen sistema de evaluación, pero por otra parte es una característica muy tentadora para todo spammer, que navega de página en página dejando enlaces a su propia web.

Mi consejo es evitar en lo máximo posible realizar spam de este tipo. Deja comentarios en blogs de forma inteligente (cuando tengas algo que aportar, no lo hagas porque sí para dejar tu enlace), establece firmas en foros o grupos de noticias a tu blog (de forma decente, nada de ampliar el tamaño del texto o ponerle colores chillones o imagen en grande para que se vea), trackbacks (sólo cuando sea necesario y objetivo), etc...

Yo, por ejemplo, odio el intercambio de links. Sin embargo, Google le da importancia si la temática es similar y los enlaces son naturales. Mi consejo es utilizar el intercambio de links sólo y exclusivamente cuando la web a la que enlazas te guste e interese y no cuando otras personas te propongan un intercambio. Así favorecemos realmente el contenido de calidad y no promovemos el spam.

Otro factor bastante importante según algunas encuestas es la reputación del autor. Evidentemente, si eres un spammer que va por muchas páginas dejando enlaces de spam, no tardarás mucho en perder credibilidad.

Todo esto, sin mencionar el atributo rel=nofollow que muchas páginas poseen (en los comentarios, por ejemplo). Este atributo no hace más que avisar a Google de que no debe seguir los enlaces, ideal para evitar comentarios de spam, ya que generalmente buscan aumentar su reputación consiguiendo enlaces.

Establece feeds RSS

Los feed RSS son un invento muy novedoso e interesante. Se trata de un fichero con la información de los últimos artículos publicados en la web. Así cualquiera puede obtener ese fichero a través de un gestor y de todos los RSS de webs que posea, ver cuales se han actualizado de una vez, sin tener que entrar a cada web independientemente.

Como autor de blog, debes buscar la forma de proveer un sistema de RSS (Atom u otro) para que los lectores puedan recibir las actualizaciones del sitio cómodamente. Esto aumentará tu número de visitas casi seguro. Si eres usuario de Blogger asegurate de marcar la opción para activar este tipo de ficheros.

Servicios interesantes relacionados con el tema pueden ser FeedBurner o FeedBlitz. Desde gestores de feeds RSS como Bloglines o Google Reader puedes ver el número de suscriptores que tiene tu blog.

Sitemaps: Mapas de sitio

Si estas empezando, puede ser bastante lento (¡y desesperante!) esperar a que el robot de Google pase por tu sitio para indexarlo, ya que el bot de Google tiene que "encontrar" un enlace a tu blog en otra página y entonces pase a revisarlo. Sin embargo, existe una forma relativamente sencilla de indicarle a Google todas las páginas de tu sitio y acelerar el sistema de una forma muy rápida.

Se trata de generar un mapa del sitio (en formato RSS, citado en el punto anterior) para que Google acceda a ese fichero y vea los enlaces que existen, los indexe y si cambian vuelva a indexarlo. Para ello hay que generar una lista con todos los artículos y secciones de la página, con su fecha de última actualización (junto a otros parámetros opcionales).

En Google Webmasters puedes realizar varias acciones relacionadas: Herramientas de sitemaps para Google, Enviar página web a Google e incluso un foro de discusión de Google entre otras cosas.

La generación del sitemap es muy sencilla, pero si no quieres complicarte la vida, puedes obtener un programa gratuito como VIGOS Gsitemap, que genera el fichero automáticamente. Para otros buscadores como Yahoo! también existe un sistema de sitemaps.

Contenido de calidad

Como mencioné anteriormente, el contenido de un blog es un algo muy importante. Un contenido de calidad no sólo atraerá a gente interesada por los artículos escritos, sino que además las visitas aumentarán y los buscadores también se interesarán por tu sitio. Siempre es bueno escribir sobre una temática que se domine, aunque no tiene porque ser imprescindible.

Algo que sí es imprescindible, es realizar una correcta redacción. Los lectores de una página web se interesan muchísimo (y les atrae bastante) la forma de escribir de su autor. Fallos de ortografía o gramática son imperdonables. Para evitarlo, existe un complemento magnífico para el navegador Firefox: diccionarios ortográficos. Ellos te remarcarán las palabras mal escritas, como cuando editamos un documento de Microsoft Word.

Facilidad de acceso y optimización

Punto muy importante. Muchas de las páginas que visito (atención sobre todo usuarios de espacios de MSN o Blogger) contienen una barbaridad de contenido en su página principal (probablemente debido a la inexperiencia de los autores).

Una página principal (así también como cualquier artículo concreto) no debe exceder de un determinado peso total en conjunto de todos sus ficheros (texto, imagenes, contenido multimedia, etc...).

Por ejemplo, algunos espacios de MSN visualizan de una vez las últimas 9 entradas. Cada entrada tiene 4 o 5 imagenes que ocupan unos 50kb cada una. En principio esto no supondría ningún problema, pero (50 * 4) * 9 = 1.800. ¡Casi 2 megas de página! Imaginaos si el pobre usuario que quiere verla tiene modem de 56Kb (conexión de 4,5kb/s). ¡Necesitaría casi 8 minutos de espera para tener cargada la página y comenzar a verla!

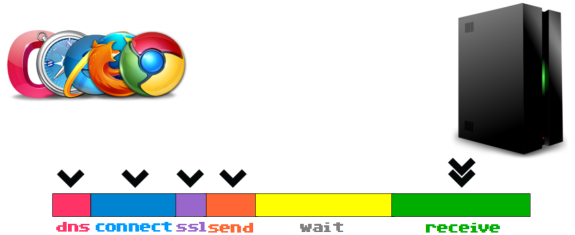

Para ello, existe -nuevamente- una extensión para Firefox llamada Life of request info. Al tenerla instalada y cargar una página, en la zona inferior del navegador aparecerán varios datos:

- Tiempo de latencia: Espera desde que el usuario hace click hasta que comienza a transmitirse información.

- Tiempo de carga: Espera desde que comienza a recibirse información hasta que se completa la carga de la web.

- Tamaño de la página: Texto, imagenes, contenido multimedia, etc...

- Número de peticiones: Ficheros enlazados

Los tres últimos son los que más nos interesan. Valores aceptables podrían ser:

- Latencia entre 0-3seg (mayores podrían deberse a mala configuración de la conexión del PC o servidor web muy lento)

- Carga web 0-45seg (cuanto menos mejor, mayores de 45 segundos, web bastante lenta)

- Tamaño entre 15-200kb (si es mayor planteate el reducir el tamaño de tu página: menos imagenes, menos cantidad de entradas / articulos, etc...) Date cuenta que cuanto más tamaño, más tardará en cargar.

- Peticiones entre 15-200 (más de 100 peticiones se considera una página bastante cargada de contenido).

Evidentemente, estos datos son solo orientativos. Si te interesa la optimización web, aquí tienes una conferencia que di en la Tenerife LAN Party 2012 sobre técnicas para mejorar la velocidad, posicionamiento y rendimiento de tu web.

Diseño

Por último, y no por ello lo menos importante: el diseño web de la página. Muchos autores lo consideran algo secundario, aunque para mi es tan primario como cualquier otro punto.

Personalmente, considero que el diseño gráfico de un blog o página web debe ser diferente al resto (diseños idénticos o plantillas muy usadas dan impresión de poca frescura). Debe ser llamativo pero no cargante, usar colores que no cansen la vista, pero no muy monótonos e imágenes muy vistosas y agradables.

En el artículo Formatos de imágenes: Guía de optimización tienes una completa y detallada lista de formatos de imágenes, con sus características y particularidades, ideales para conseguir el mínimo tamaño de imagen posible (y descarga más rápida)) con la máxima calidad posible. También puedes acceder a este listado de 12 aplicaciones para optimizar imágenes.

También es importante remarcar que sería bueno que respetasen los estándares marcados por la W3C, que aunque Google no es muy estricto con esto, cuanto más sencilla y mejor procese la página, mejor te "puntuará".

No olvidar la accesibilidad: no abusar del Javascript y proporcionar métodos alternativos para navegadores sin javascript, probar diferentes resoluciones y navegadores y asegurarse que en todos la página es navegable. Si además, proporcionamos una versión para dispositivos móviles, PDA y demás, inmejorable.

Si quieres más información sobre como posicionarte mejor en Google y conseguir más visitas, echa un vistazo a mi guía de trucos y consejos de posicionamiento en Google.